Raspberry: portable Retropie-Box

Vor geraumer Zeit habe ich mir einen Raspberry Pi4, genauer die 8GB Variante, in eine Holzbox von TEDI verbaut. Die Box bietet mir Raum für den Kontroller, als auch 2 Powerbanks für die Stromversorgung. Da ich noch einen 7″ Monitor hatte, kam mir die Idee, diesen für eine portable Box mit Retropie zu benutzen. Dementsprechend habe ich mir die Holzbox erworben und nach meinen Vorgaben umgestaltet.

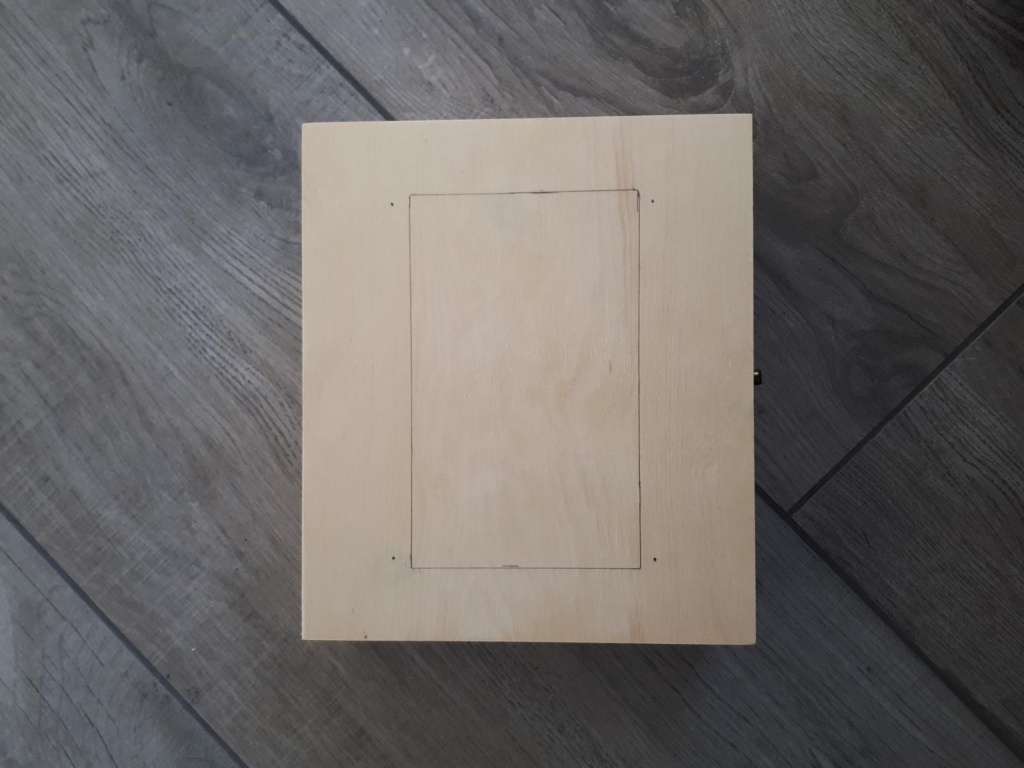

Die Größe des Displays habe ich aus dem Deckel geschnitten. Zuvor hatte ich mir die Maße aufs Holz gezeichnet.

Die kleinen Platten für die einzelnen Behälter habe ich dafür benutzt, mir meine individuelle Größe zu gestalten. So habe ich nun 3 unterschiedlich große Behälter, jeweils für die Powerbanks, für den Kontroller und für die Kabel.

In den Seiten habe ich verschieden Einkerbungen für z.B. USB Kabel geschnitten. Nichtdestotrotz ist die Box komplett portabel und benötigt, solange die Powerbank genug Energie liefert, keine angeschlossenen Kabel.

Als OS kommt natürlich retropie zum Einsatz. Somit kann ich unterschiedliche Emulatoren benutzen, um die unterschiedlichsten Spiele zu spielen. Diese müssen selbstverständlich als Rom zur Verfügung stehen.

Zurzeit benutze ich den N64 Emulator am meisten. Dort habe ich z.B. Donkey Kong 64 und Super Mario 64, zwei Spiele, die mich in meiner Kindheit begleitet haben :).