externe USB-SSD in Proxmox einbinden

In diesem Beitrag zeige ich euch, wie ihr eine externe USB-SSD in Proxmox einbinden könnt. Nur ein einfaches “Plug and Play” ist es in diesem Fall nicht. Die Disk muss vorweg korrekt formatiert und gemountet werden, damit Proxmox die neue Platte finden kann – Proxmox kann dies nicht out of the box.

Als erstes ermitteln wir die USB-SSD mit fdisk. Meist ist sie als eine /dev/sda, wie in meine Fall, oder ähnlich eingebunden.

fdisk -l Disk /dev/sda: 1.82 TiB, 2000365371904 bytes, 3906963617 sectors Disk model: Extreme 55AE Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 1048576 bytes Disklabel type: gpt Disk identifier: 5623AD37-4AA9-4134-BC1A-565998A00786 Device Start End Sectors Size Type /dev/sda1 2048 3906961568 3906959521 1.8T Linux filesystem

/dev/sda1 ist die Partition und diese formatieren wir in eine ext4 Dateisystem.

mkfs.ext4 /dev/sda1

mke2fs 1.47.0 (5-Feb-2023)

Discarding device blocks: done

Creating filesystem with 488369940 4k blocks and 122093568 inodes

Filesystem UUID: c1408055-3603-45c5-8e7a-ca793faa6011

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,

4096000, 7962624, 11239424, 20480000, 23887872, 71663616, 78675968,

102400000, 214990848

Allocating group tables: done

Writing inode tables: done

Creating journal (262144 blocks): done

Writing superblocks and filesystem accounting information: done

Verläuft die Formatierung erfolgreich, mounten wir die Platte in ein angelegtes Verzeichnis hinein. Den Mount-Point könnt ihr euch dabei selber aussuchen.

mkdir /mnt/ext_ssd mount /dev/sda1 /mnt/ext_ssd/

Nachdem die Platte gemountet ist, ist es nun über Proxmox möglich, diese einzubinden. Jedoch würde der Mount nach einem Neustart wieder verschwinden. Abhilfe schafft ein Eintrag in die /etc/fstab. Dazu ermitteln wir die UUID unserer neu erzeugten Partition

root@pve:/mnt/ext_ssd# blkid | grep sda1 /dev/sda1: UUID="c1408055-3603-45c5-8e7a-ca793faa6011" BLOCK_SIZE="4096" TYPE="ext4" PARTLABEL="Extreme SSD" PARTUUID="367c946e-fc02-4fd0-be7d-085323bbc320" root@pve:/mnt/ext_ssd# systemctl daemon-reload

Haben wir die UUID ausfindig gemacht, setzen wir einen neuen Eintrag in /etc/fstab. Ihr könnt dabei die Zeile von unten kopieren, müsst allerdings die UUID und den Mount-Point, hier /mnt/ext_sdd, an eure Gegebenheiten anpassen. Falls ihr ein anderes Dateisystem als ext4 genommen habt, müsst ihr auch diese anpassen.

root@pve:/mnt/ext_ssd# vi /etc/fstab UUID=c1408055-3603-45c5-8e7a-ca793faa6011 /mnt/ext_ssd ext4 auto,nofail,sync,users,rw 0 0

Nach dem die Zeile gesetzt ist, überprüft, ob die Partition gemountet werden kann

root@pve:/mnt/ext_ssd# mount -a

Sollte kein Fehler kommen und im besten Falle nur die nachfolgende Meldung, könnt ihr den daemon neu laden und die Partition sollte bei jedem Neustart mit gemountet werden.

mount: (hint) your fstab has been modified, but systemd still uses<br>the old version; use 'systemctl daemon-reload' to reload.

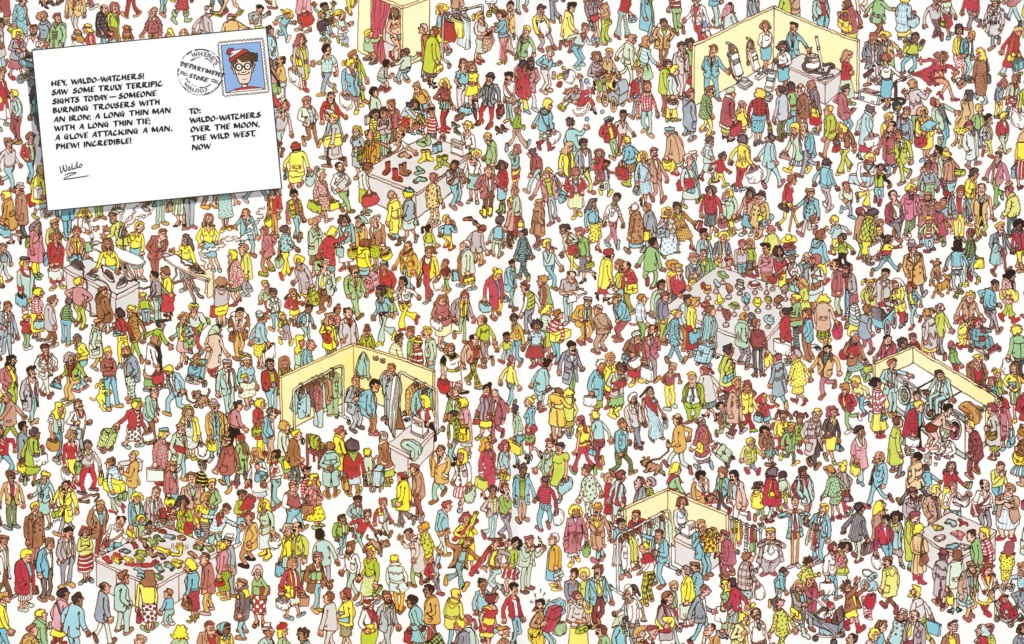

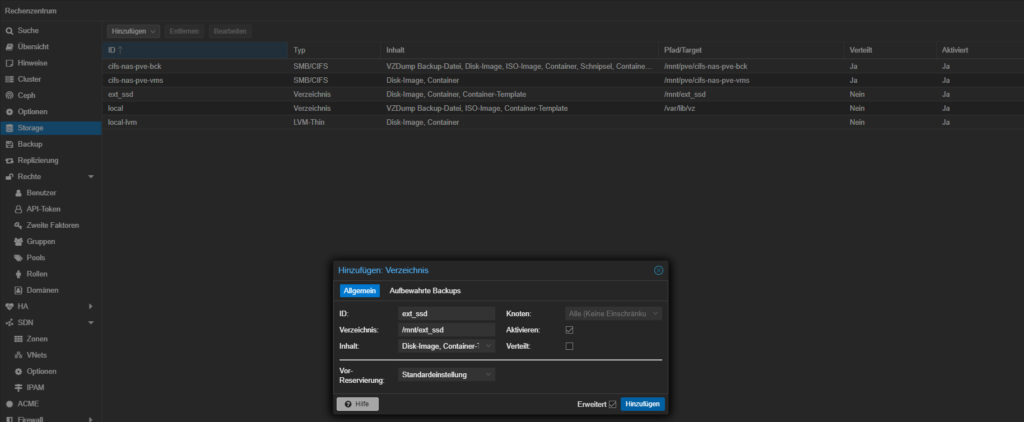

Nach der relativ einfachen Initialisierung der USB-SSD auf Betriebssystemebene, machen wir die Platte jetzt noch Proxmox bekannt, damit wir dort Images, ISOs, etc. ablegen können. Geht dazu auf oberste Ebene “Rechenzentrum” und fügt einen neuen Storage vom Typ “Verzeichnis” hinzu. Setzt eine ID und in das Verzeichnis-Feld den Mount-Point, sowie die Labels.

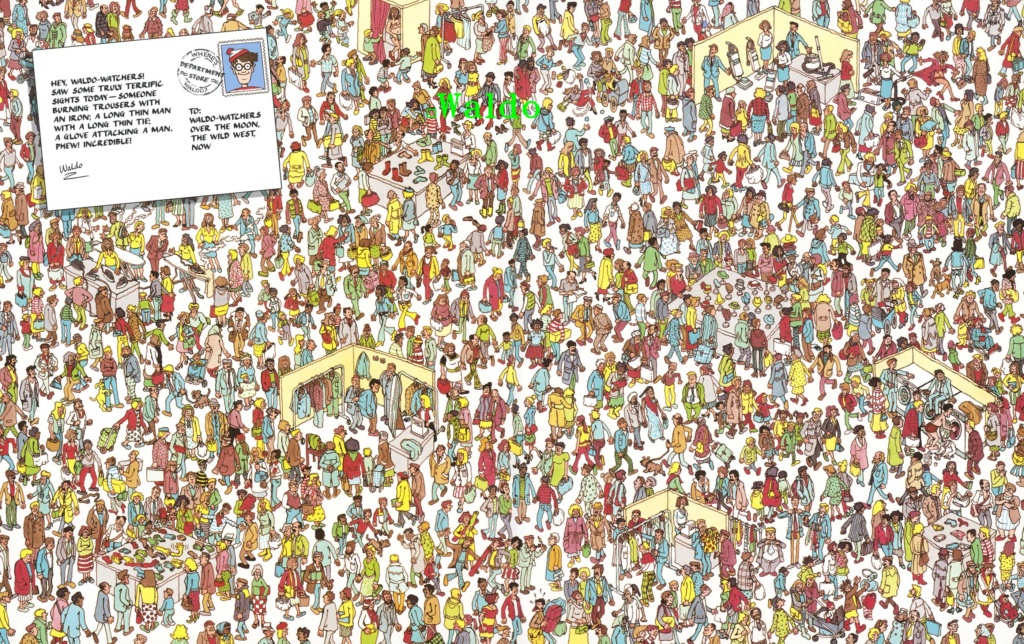

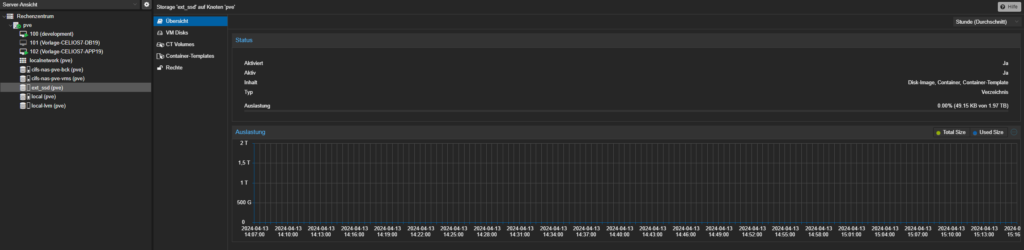

Auf euren Knoten sollte der neu eingefügte Storage sichtbar sein. Dort könnt ihr sehen, wieviel Speicher noch frei ist und andere wichtige Informationen

Damit könnt ihr eure externe SSD als Datenspeicher in Proxmox benutzen.